Können wir Künstlicher Intelligenz vertrauen, Julia Reinhardt?

Was Künstliche Intelligenz (KI) heute schon leistet, ist spätestens seit dem Rummel um ChatGPT einer breiten Öffentlichkeit bekannt. Doch wer hat den Chatbot trainiert? Wie unvoreingenommen ist der programmierende Mensch dahinter? Und wie kann die Gesellschaft sicherstellen, dass KI-Anwendungen ethische Standards einhalten? Antworten von Julia Reinhardt, Mercator Senior Fellow am AI Campus in Berlin.

Wäre Künstliche Intelligenz (KI) menschlich, befände sie sich gerade im Teenager-Alter. Sie provoziert, zieht Aufmerksamkeit auf sich, hat klare Meinungen und liegt doch bei vielem noch falsch. Julia Reinhardt, Mercator Senior Fellow am Merantix AI Campus in Berlin, begleitet selbstlernende Systeme seit ihren Anfängen. „Ich vergleiche KI ungern mit Menschen. Sie ist ein von Menschen gemachtes Instrument. Wenn ich Menschen allerdings in ihrer Nutzung von KI beobachte, dann kann ich auch von Teenager-Extremen sprechen – von himmelhochjauchzend bis zu Tode betrübt“, sagt Reinhardt. Sie erzählt von einer Abendveranstaltung zu ChatGPT. „Ein Teilnehmer war so begeistert von den Möglichkeiten, dass er forderte, die KI auch mit rassistischen Fragen auf die Probe stellen zu dürfen – es müsse hier grenzenlose Freiheit geben.“

Solche Forderungen betreffen ihr Arbeitsfeld. Die Grenzen von KI müssen laut Reinhardt gerade da verlaufen, wo es auch in der „bisherigen Welt“ Grenzen gibt und zum Beispiel Menschenrechte verletzt werden – wo KI also Entscheidungen trifft, die massiven Einfluss auf unser Leben haben. Die 47-Jährige sieht ihre Aufgabe darin, dass KI-Systeme sich zu etwas Sinnvollem entwickeln und sich mit ihrer Hilfe Schäden vermeiden lassen. Und dafür muss die ehemalige Diplomatin vor allem eines: viel reden und vermitteln.

Dafür ist Reinhardt aus San Francisco nach Berlin gezogen und nennt den AI Campus im Berliner Bezirk Mitte ihre „Homebase“. Dort versammeln sich Start-ups und Tech-Vordenker*innen – Entwickler*innen zukünftiger KI.

Angst vor dem AI Act

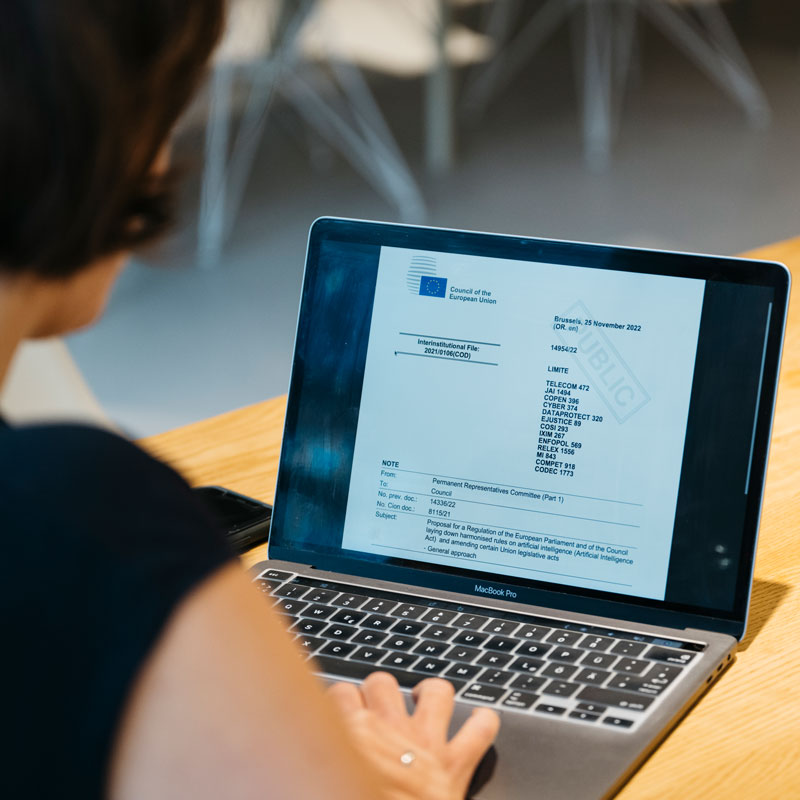

Welche Beweggründe und Ziele Menschen haben, wenn sie Maschinen mit Daten füttern und Algorithmen programmieren, bleibt oft im Dunkeln. Dabei betrifft es uns alle. Denn immer häufiger begegnen uns automatisierte Entscheidungen in immer mehr Lebensbereichen. Auf welcher Basis Künstliche Neuronale Netze und andere Formen des maschinellen Lernens agieren, wird jedoch häufig nicht offengelegt. Deshalb arbeitet die EU an einem der ersten Gesetze weltweit, das KI in allen Lebensbereichen regulieren soll: dem Artificial Intelligence Act (AI Act). Was bürokratisch klingt, sieht Reinhardt als wichtige Leitplanke für einen gesellschaftlich verantwortungsvollen Umgang mit Künstlicher Intelligenz.

Auf dem AI Campus berät Reinhardt Entwickler*innen, wie sie umsetzen, was der AI Act von ihnen künftig verlangen wird. Die Entwickler*innen freuen sich zwar, dass ihre Arbeit durch den Hype um ChatGPT anders wahrgenommen wird, gleichzeitig wiegt ihre gesellschaftliche Verantwortung schwer: Sie empfinden sie mehr als Last denn als Chance. „Manche Entwickler*innen lehnen eine KI-Regulierung kategorisch ab, weil sie ihr Geschäftsmodell in Gefahr sehen. Sie befürchten, dass die EU die Weiterentwicklung von KI in Europa stoppen könnte. Dabei ist das nicht der Fall. Im Gegenteil: Wenn wir uns heute kluge Gedanken über Standards für KI machen, dann können uns automatisierte Entscheidungen später viel Mühe und Zeit sparen. Wenn wir es also heute gut machen und umsetzen, dann können wir KI vertrauen – zumindest nicht weniger als dem Menschen!“

Wenn die gebürtige Kölnerin über KI spricht, dann ist die Begeisterung spürbar, mit der sie Probleme angeht und die Welt ein Stück weit besser machen möchte. Etwa wenn sie an einem Frühlingstag in den Co-Working-Räumen des AI Campus mit einem Entwickler des Start-ups Vara zusammensitzt, das Ärzt*innen bei der Brustkrebsdiagnose unterstützt. Eine andere Entwicklerin arbeitet währenddessen an einem KI-Tool für Versicherungen, das über Schadensfälle entscheiden soll – gründlicher und fairer als Menschen mit ihren Vorurteilen.

Die KI-Regulierung funktioniert wie eine Leitplanke: Auf einer kurvigen Gebirgsstraße sorgt sie dafür, dass du unbesorgter fahren und schneller ans Ziel kommen kannst.

Reinhardt erklärt den AI Act so, dass die Entwickler*innen damit etwas anfangen können. So spricht sie konkret darüber, wie sie die Vorgaben für die Programmierung und Nutzung von KI erfüllen können, zum Beispiel indem sie ihre Arbeit transparenter machen. „In den Gesprächen möchte ich in erster Linie verstehen, was den Entwickler*innen wichtig ist. Wir schauen gemeinsam auf ihre Ziele und entwickeln eine Strategie“, sagt Reinhardt. Es geht um Fragen wie: Welche Daten brauche ich überhaupt für ein gutes Modell? Und sollte ich zusätzliche Personendaten vielleicht erst gar nicht abfragen, weil sie mich im Datenmanagement belasten und mein Produkt nicht besser machen? Wie belege ich, dass ich mich um Transparenz, Copyright, Datenschutz, Sicherheit und qualitativ hochwertige Trainingsdaten gekümmert habe? Reinhardt sagt: „Wenn du durch eine gute Dokumentation nachweisen kannst, dass du dir Gedanken gemacht hast, ist das sinnvoll. Denn sollte etwas schiefgehen, kannst du darlegen: Ja, unser Algorithmus hat hier einen Fehler gemacht, aber so und so haben wir versucht, das zu vermeiden, und das sind unsere Korrekturmaßnahmen. Der Vorteil ist ja, dass die Systeme lernfähig sind.“

Reinhardt möchte dazu beitragen, dass die neue Regulierung den KI-Entwickler*innen hilft. Sie versucht es mit einer Metapher: „Die KI-Regulierung funktioniert wie eine Leitplanke: Auf einer kurvigen Gebirgsstraße sorgt sie dafür, dass du unbesorgter fahren und schneller ans Ziel kommen kannst.“

Verantwortung klingt besser als Risiko

Auf Reinhardts Laptop klebt das Logo des Vereines „Women in Security and Privacy“, daneben eine Erinnerung an ihre Zeit in San Francisco. Als Mozilla Fellow in Residence untersuchte sie in Kalifornien die Möglichkeiten und Grenzen europäischer Ansätze hin zu vertrauenswürdiger Künstlicher Intelligenz im Silicon Valley. Die globale Initiative „Woman in AI Ethics“ hat Reinhardt für ihr Engagement vor Kurzem ausgezeichnet und sie auf die Liste der 100 brillanten Frauen in AI Ethics gesetzt. In Reinhardts Arbeit überschneiden sich Welten, sie ist die Schnittstelle zwischen KI-Unternehmen, Staat und Zivilgesellschaft. Ihre Hauptaufgabe besteht darin, zu übersetzen: von EU-Behördensprache in Start-up-Sprech, von der Welt der unzähligen Abstimmungsschleifen in die Welt des binären Systems zwischen 0 und 1. So sorgt sie dafür, dass die Regulierungsvorhaben der europäischen KI-Entwicklung auch in die Praxis umsetzbar sind und keine Papiertiger werden.

Ein weiteres Beispiel ihrer Arbeit als Dolmetscherin zwischen den Welten: Der EU-Gesetzesentwurf zum AI Act basiert auf einem risikobasierten Ansatz. Das heißt konkret: Künstliche Intelligenz und ihre Anwendungen müssen Anforderungen erfüllen, die auf dem von der EU festgelegten Risikoniveau basieren. Geplant ist auch eine EU-Datenbank, in der Hochrisiko-KI-Systeme registriert werden, die in Bereichen wie Strafverfolgung, Einstellungsverfahren, Medizin oder im Verkehr zum Einsatz kommen. Reinhardt redet stattdessen von einem „verantwortungsbasierten“ Ansatz. Das klinge positiver und „macht den Entwickler*innen bewusst, wie viel Verantwortung sie tragen und übernehmen dürfen bei dem, was sie tun“. Das könnte viele überzeugen, den AI Act weniger kritisch zu sehen.

Von der Diplomatin zur Brückenbauerin

In ihrem Leben hat Reinhardt schon oft Menschen überzeugt, das kann sie aus ihrer Sicht gut. Aber sie lässt sich auch selbst überzeugen, lernt gerne dazu. „Auf dem AI Campus in Berlin empfinde ich mich schon ein wenig als Sonderling. Ich laufe ja als das personifizierte gesellschaftliche Gewissen durch die Büros der Entwickler*innen. Aber es macht Spaß, wenn die Treffen richtig konstruktiv werden und wir voneinander lernen“, sagt die Frau, die nie Informatik studiert hat.

Weil sie sich immer schon für Europa begeistert hat, studierte sie Europäische Studien und Internationale Politik in Paris, Berkeley und Osnabrück. Im Libanon lernte sie Arabisch. Nach dem 11. September 2001 war sie beim Auswärtigen Amt zunächst in der politischen Abteilung für Krisenländer tätig, später ging sie in die Europapolitik. Von 2002 bis 2015 war sie deutsche Diplomatin in Rom, Berlin und San Francisco, wo sie an den ersten Entwürfen der EU-Datenschutz-Grundverordnung mitarbeitete. „Da ging es auch darum, den Start-ups die Angst zu nehmen, die neue Regulierung könnte sie in den Ruin treiben – unterschiedslos und egal, wie sie sich vorbereiten“, sagt Reinhardt und lacht.

Als sie nach San Francisco ging, zunächst als Diplomatin am Generalkonsulat, war sie mit ihrem Europawissen etwas Besonderes und eckte an, wenn sie nach den ethischen Standards von neuen Erfindungen der Tech-Visionär*innen fragte. Doch auch hier hörte Reinhardt zu, ließ sich von den Visionen der Gründer*innen begeistern und gewann so das Vertrauen der Entwickler*innen. Während der zehn Jahre in der kalifornischen Stadt lernte sie große Technologieunternehmen und kleine Start-ups kennen und knüpfte Kontakte zu politischen Entscheider*innen. „Ein riesiges Netzwerk, das ich nach meinem Ausscheiden aus dem diplomatischen Dienst und meiner Zertifizierung als Datenschutzbeauftragte weiter ausgebaut habe. Ich habe mich eingehend mit dem Datenschutz für kleine Technologieunternehmen beschäftigt und mich darauf spezialisiert, ihnen dabei zu helfen, die neue EU-Datenschutz-Grundverordnung einzuhalten. Das war mein Weg in die Technologieregulierung und hat mir klargemacht, was es bedeutet, Leitplanken um unsere glänzenden neuen Tools und die Art und Weise, wie sie unsere Welt verändern, zu bauen.“

Mensch und KI zusammen im riesigen Versuchslabor

Privat nutzt sie selbstlernende Systeme dann, wenn KI für sie ein Problem lösen kann. „Zuletzt habe ich KI-basierte Software benutzt, um Bilddateien für einen Geburtstagskalender zu verbessern“, sagt Reinhardt, die Mutter von drei Schulkindern ist. „Das ist eine harmlose Anwendung, ohne politische Relevanz. Aber KI ist ja in viele Produkte integriert, daher finde ich die Kennzeichnung so wichtig. Ich möchte abwägen können, was ich nutze – und was nicht. Mir ist es wichtig, den Zweck des Algorithmus zu verstehen.“ Und KI entwickelt sich rasant. „In vielen Anwendungsfällen sehe ich unsere Rechtsordnung vor großen Herausforderungen. Wir können nicht einfach zusehen und die Unternehmen machen lassen. Aber ob unsere Regulierungsinstrumente dafür geeignet sind, das wird sich in allernächster Zukunft zeigen. Mich besorgt schon, dass wir uns zurzeit praktisch schutzlos in einem riesigen Versuchslabor befinden. Demokratie, Menschenrechte, Haftung, Urheberrechte: Sie stehen auf dem Spiel, und vulnerable Bevölkerungsgruppen trifft es zuerst. Diesen Herausforderungen müssen wir uns stellen – und gleichzeitig die großen Chancen ermöglichen.“

Mercator Fellowship-Programm

Das Mercator Fellowship-Programm bietet seinen Stipendiat*innen den Freiraum, sich explorativ und ideenreich einem Forschungs- oder Praxisvorhaben zu widmen.